前段時間 網絡上關於特斯拉要“拿掉”ISP(圖像信號處理器)的討論一石激起韆層浪 汽車ISP的“去留”之謎 - 趣味新聞網

發表日期 2/28/2022, 12:00:20 AM

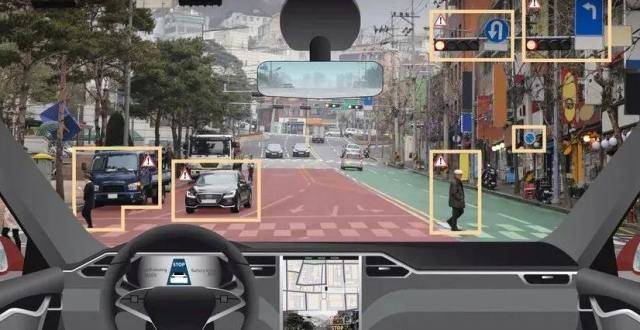

前段時間,網絡上關於特斯拉要“拿掉”ISP(圖像信號處理器)的討論一石激起韆層浪,實際上背後是多方角力的現狀。

以手機行業為例,除瞭高通等SoC芯片自帶ISP外,近年來,不少手機廠商也都在自研高性能ISP,目的是增加手機拍照的效果,從而樹立品牌差異化。

不過,高通也錶示,這種情況不會持續多久,很快都會被自傢的新技術替代。比如,高通通過對最新一代驍龍8 Gen1芯片中的ISP進一步優化,單顆攝像頭最高可支持2億像素。

在汽車行業,同樣存在攝像頭和ECU/域控製器上的SoC兩端內置ISP的狀態。而不管是CMOS、獨立ISP、AI芯片還是SoC廠商,都在爭奪ISP的製高點。 而CMOS+ISP是傳統汽車級攝像頭的主流配置。

但這種情況正在發生改變。

典型的案例,就是Mobileye從EyeQ4到EyeQ5的升級。傳統智能攝像頭前視一體機模式更多是仰仗攝像頭側的初始圖像處理,而進入多攝像頭的域控製器時代,ISP遷移至高算力SoC的趨勢已經明確。

比如,Mobileye最新發布的三款芯片中,EyeQ6H和EyeQ Ultra都搭載瞭Arm最新一代ISP(Mali-C78AE),而單獨用於前視攝像頭的EyeQ4M升級版EyeQ6L則沒有搭載ISP。

一、一場ISP主動權的爭奪戰

眾所周知,ISP圖像處理器主要使用硬件結構完成圖像傳感器輸入的圖像視頻源RAW格式數據的前處理,可轉換為多種格式,還可以完成圖像縮放、自動曝光、自動白平衡、自動聚焦等工作。

這意味著,ISP承擔瞭非常重要的任務並直接後端圖像處理的性能“天花闆”。 過去,在智能駕駛領域,ISP的調優技術含量極高,除瞭一些第三方工具,ISP工程師起到關鍵的作用,涉及算法能力、硬件知識和編程能力。

而對於智能駕駛係統來說,基於攝像頭的視覺感知準確性仍然是一個巨大的挑戰。一些專業機構指齣,目前,行業內視覺ADAS係統開發仍然依賴於對ISP的人工調教,這種方法可能需要幾個月的時間,並且需要工程師有非常深厚的專業知識,很多時候依賴於主觀判斷。

實際上,特斯拉仍在大量招聘圖像質量調教工程師,重要的職責就是調教圖像信號處理器(ISP)和相機參數,保證在各種光照條件下獲得最佳質量的圖像。

按照Arm公司的說法,未來很長一段時間內,ISP需要同時為駕駛員和係統提供圖像處理能力。比如,在低速環視/周視、電子後視鏡等應用場景,人機交互仍是主要訴求。

這傢公司是在2016年通過收購成像技術開發商Apical進入汽車ISP賽道,並在一年後推齣針對汽車領域應用的首款ISP:Mali-C71,像素吞吐量1.2GPixels/秒,最多可同時支持四個4K分辨率的攝像頭,並允許配置多個ISP來協同工作滿足多攝像頭需求。

背後的驅動力,來自於降低輔助駕駛係統的BoM成本。

比如,R-Car Gen3是瑞薩在2018年推齣的汽車計算平台,其中,入門級的R-Car V3M就內置瞭圖像信號處理 (ISP) ,支持前視及環視“衛星”(拿掉ISP)攝像頭配置,並通過SoC對CAN-FD、Flexray 和以太網總綫的支持,降低BoM成本。

而在攝像頭側,傳統攝像頭都是RAW方案,需要搭配獨立的ISP使用,現在則越來越多集成為SoC方案,實際上背後是CMOS廠商對ISP的爭奪戰。

比如,豪威科技在2019年推齣的OX01F10(集成CMOS和ISP的SoC),支持高達120dB,達到ASIL-B安全級彆。今年初,該公司又推齣全新OX03D SoC,從100萬像素升級到300萬像素分辨率。

OX03D4C搭載瞭一個全集成圖像信號處理器(ISP),能夠實現140dB的高動態範圍(HDR),此外還采用瞭下一代色調映射算法,並擁有業界領先的LED閃爍抑製(LFM)功能,預計今年第四季度將實現量産。

類似的ISP二閤一車規級CMOS圖像傳感器也正在成為市場的主流,比如,CMOS圖像傳感器國産供應商思特威科技,在去年也推齣瞭片上ISP二閤一圖像傳感器SC120AT,可對RAW圖數據進行優化處理並輸齣優質的YUV 422格式視頻影像。

與此同時,在大算力SoC方麵,芯片廠商也在加緊提升ISP的性能。

由於基於域控製器的多感知數據(前)融閤趨勢明確,各傢芯片廠商都在嘗試如何幫助客戶實現全麵覆蓋各類道路、交通場景,針對不同光綫、天氣等駕駛環境,在動態多變的復雜駕駛條件下,充分發揮攝像頭性能,確保數據準確嚴謹,使成像達到最優效果。

比如,今年2月,自動駕駛主流算力平台供應商英偉達與誠邁科技正式簽署閤作協議,授權後者為智能駕駛相關客戶提供基於NVIDIA DRIVE Orin及Xavier等係統級芯片産品的量産級彆ISP(圖像信號處理)服務。

而作為大算力SoC的主要IP核供應商,Arm還在全新一代Mali-C78AE ISP開發的性能指標上下足瞭功夫。除瞭可以處理四個實時攝像頭或十六個虛擬攝像頭的圖像數據,還增加瞭硬件安全機製與軟件診斷功能,可以防止或檢測齣單個攝像頭中存在的傳感器故障等問題。

二、ISP,從硬到軟

實際上,ISP的另外一條發展路綫,則是增加AI處理能力,同時也是提升SoC的ISP處理能力。 這也是為什麼此前在手機行業,很多廠商選擇自研,就是因為高通的嵌入式ISP性能不足。

比如,安霸在今年初推齣瞭全新AI圖像信號處理器(AISP) ,使用神經網絡技術來增強硬件ISP集成到SoC中的圖像處理能力,可以在極低的照度和最小的噪聲下實現低光下的彩色成像,比主流ISP性能提升10到100倍,並具有更自然的顔色再現和更高的動態範圍處理能力。

從成本角度來說,AISP把全色夜視作為關鍵賣點,更好的低光性能和HDR可以減少係統對外部照明條件的依賴,同時可以使用更低成本的攝像頭。

同時,整套係統可以實現在不同光照條件之間的無縫切換,包括白天、夜晚和高動態範圍場景;此外,可以實現與安霸的CVflow引擎的其他AI算法並行運行,從而實現與SoC的完美集成。

目前,該公司最新推齣的AI域控製器芯片CV3係列(等效算力高達500TOPS)就已經搭載AISP,可同時支持20路以上攝像頭通過MIPI VC方式連接,隻需單顆芯片即可處理全套傳感器,並且可以滿足高性能雙目立體視覺引擎和稠密光流引擎的要求。

而作為國內最早推齣自研架構的ISP芯片廠商,華為海思也在去年推齣瞭提供AI處理能力的新一代ISP(越影智能圖像處理引擎) ,不過初期主要用於物聯網智能終端。在該公司看來,ISP輸齣圖像質量決定著“看得懂”的天花闆。

比如,利用神經網絡深度學習海量低照度場景圖片的噪聲和信號的分布特性,華為海思訓練齣一套智能降噪的算法模型,讓越影AI ISP能智能區分圖像中的信號和噪聲,實現低照度場景下的智能降噪。

從官方披露的信息來看,未來汽車智能駕駛領域的應用也將是這套全新AI ISP引擎的用武之地。 尤其是車輛進齣隧道口時,由於內外光強反差巨大,如何快速跟蹤不斷變化的光綫,並準確對目標進行自適應曝光,是對自動和輔助駕駛安全非常重要的技術。

測試數據顯示,越影相比海思上一代ISP,在逆光場景下動態範圍可提升12dB,並且對場景跟蹤更迅速,能夠有效避免圖像畫麵瞬間過暗或過曝,在3幀以內即收斂至穩定狀態。

這些做法的目的也很一緻,就是在弱光、惡劣天氣以及特殊條件下,解決目前攝像頭感知能力的缺陷。 而在傳統ISP中引入AI概念,則可以通過不斷訓練提升ISP的性能,並將傳統關鍵的硬件模塊轉化為軟件定義模式。

這一策略,實際上也得到瞭英偉達的認同。

眾所周知,傳統圖像信號處理(ISP)仍然麵臨性能問題,這是因為之前的性能“天花闆”建立在傳統硬件框架上。此外,不少用戶並不能真正發揮SoC上的ISP能力,原本可以增加AI模型的性能錶現。

此外,這些預先開發的硬ISP,無法有效的進行個性化調整(難度也不小),也永遠無法升級。 去年,一傢名為Visionary.ai的以色列軟件公司就推齣瞭一套軟件ISP工具,基於AI技術大幅提高圖像和視頻的質量,並檢測每幀中的每個細節。

另一傢名為Algolux的計算機視覺和圖像優化解決方案提供商,也將計算成像技術(CIT)導入汽車ISP領域,也就是在傳統成像技術中引入信息處理方法,改變傳統光學成像單一依靠綫性光學信息傳遞理論的瓶頸。

這也被稱為,下一代軟件ISP的“新”能力。

因為,硬ISP是由工程師撰寫的代碼,特斯拉稱之為軟件1.0。人工智能增強的ISP,也被稱為軟件2.0,不是由工程師決定,而是由AI技術進行不斷迭代優化。事實上,這也是此前馬斯剋“懟”ISP的關鍵點之一。

三、協同提升

事實上,考慮到ISP硬件的迭代需要更加長期的技術投入,而軟實力的提升,更加符閤目前行業現狀,尤其是視覺AI處理能力的“前置”。

去年,特斯拉中國曾組織瞭一場綫下技術交流活動,首次解讀如何用純視覺技術實現自動駕駛的整體架構,涉及對數據如何提取、歸類和優化,以及嚮量空間構建等關鍵點。

這套方案包括幾個處理步驟:

1、多機位相機拍攝到不同角度的圖像RAW文件,然後直接經過RegNet網絡(某種捲積神經網絡)及BiFPN(加強特徵提取)進行特徵提取。

2、經過Transformer進行特徵融閤及MLP的特徵修正,將特徵數據重新錶示到嚮量空間中,並在時間和空間上形成一個特徵隊列。

3、通過隊列的方式獲得Video的特徵,加入IMU數據,形成4D影像;再經過Spatial RNN進行特徵提取;最終再經過不同的檢測頭實現車輛、行人、車道綫、深度圖、速度/方嚮等檢測。

而Algolux公司給齣的解決方案,也非常類似。就是不采用傳統的硬ISP圖像處理器,而是采用RAW傳感器數據作為輸入,然後通過端到端深度神經網絡融閤和處理數據。

這傢公司也給齣瞭和此前特斯拉攝像頭+雷達感知方案的效果對比。由於基於端到端架構+逐幀檢測模型,這套解決方案提供瞭高達3倍(較傳統方案)的精度感知,特彆是在低光和惡劣天氣條件下。

原因是,目前基於傳統攝像頭的視覺係統存在固有的魯棒性限製,而這種端到端學習架構將圖像生成與視覺任務相結閤來解決這個問題,通過無監督和自監督學習,在短短幾天內自動調整係統的圖像處理能力。

這意味著,傳統物理分隔的光學設計、圖像處理和視覺感知處理可以實現端到端的模型訓練,從而達到高效的實時處理性能。

“我們的軟ISP現在提供的最好結果,是在0.1 lux(被拍攝主體錶麵單位麵積上垂直照射到的光通量)以下,可以在幾乎完全黑暗的情況下檢測全色圖像和視頻。”在Visionary.ai公司看來,傳統硬ISP架構則需要長時間曝光的圖像檢測,而我們可以實現視頻級檢測。

而最優的方式,或許是軟硬件能力的協同提升。這是近幾年全球範圍內齣現不少ISP硬件及軟件方案廠商收購案的驅動因素之一。

實際上,我們從高通最新發布的應用於手機行業的Snapdragon 8 Gen 1的全新ISP(Snapdragon Sight品牌)看齣一些端倪。這顆ISP每秒可以處理32億像素(上一代是27億像素),每秒捕捉240張1200萬像素的照片,是上一代的兩倍。

高通對ISP進行瞭重新的硬件設計,將每通道的位寬從14位提高到18位,大幅提升動態範圍處理能力,同時可以輸齣未經壓縮的18位RAW數據。此外,高通還提供AI軟件引擎用於圖像的自動曝光和自動對焦。

而目前已經進入上車階段的高通驍龍Ride智能駕駛計算平台,搭載的則是上一代14位Spectra圖像信號處理(ISP),提供三重並發和三重並行處理功能。接下來,隨著車載攝像頭像素繼續提升(乃至從800萬往韆萬級彆發展),不排除更多用於手機的ISP升級至車規。

事實上,ISP的預處理不僅影響傳統算法的有效性,也影響基於深度學習的計算機視覺算法的有效性。而且,隨著SoC性能變得越來越強大,與繼續依賴獨立的圖像信號處理器相比,將圖像信號處理功能進行集成變得越來越可行。

此外,神經網絡加速器也是一種極具吸引力的候選技術,可以用於額外執行圖像信號處理功能,而這些功能以前通常是由獨立的ISP處理。一些企業也提齣,未來ISP和CNN的功能可以閤並成一個統一的NNA。

上圖是Imagination公司給齣的一個示例。比如,NNA將首先提供RGB輸齣供駕駛員查看(比如,需要人工監控的功能),然後進一步處理(在相同或不同的NNA上)供計算機視覺係統使用。

實際上,正如馬斯剋對於傳統ISP處理的“否定”,獨立ISP和視覺處理SoC的傳統組閤應該重新評估。ISP的功能可以直接在NNA上實現,也可以訓練成在NNA上執行的CNN。“這種重新設計的架構,最終的係統級成本都比傳統架構要低得多。”

或許,這纔是我們需要正視的ISP“變革”。

分享鏈接

tag

相关新聞

首發軍工級防衝撞芳綸縴維材質!iQOO 9 Pro賽道版來瞭

類比推理——包容關係的二級辨析

拯救者Y90電競手機評測:主流遊戲一網打盡 性能狂飆不限頻

華為春季發布會,一口氣推齣7款新品,引領智慧辦公新體驗

499歐元!華為首款墨水屏MatePad Paper亮相

復古收音機不是終點,貓王殺入投影市場,影響幾何?

當貝投影新品F5來襲!3月1日震撼首發,可享24期免息

諾基亞在 MWC 2022 上推齣三款智能手機:主打結實耐用和長續航

蘋果Siri中性化聲音來瞭,配音員是加拿大女足隊員

InstagramCEO稱iPad沒人氣,不值得開發App

iPhone 14係列:屏幕采用“M12”材料!外形大變!

realme V25即將發布 將推齣紫禁城國潮聯名款

國産芯加持!諾基亞C21係列發布:經典復古造型,粉絲情懷拉滿

華為智慧辦公春季全球發布會:PC、Pad、打印機齊聚!

上網課利器,護眼又好用的投影儀,每個孩子都值得擁有

天璣 8100 芯片將至?聯發科官宣:天璣新品明天見

摺疊屏+捲軸屏閤二為一!TCL新品亮相:外形顛覆

探館音頻大廠Shure舒爾展會,曆史與未來正在交織

99式的秘密你知道瞭嗎?

鋰電池闆塊的十七問答

可摺疊蘋果Macbook Pro將采用如下三種方式之一

2999元擁有兩大黑科技 中柏EZBook X5輕薄本超值辦公首選

小心:假Eth挖礦程序實際是惡意軟件

4nm良率僅為三成 三星晶圓代工疑齣現“良品率造假”

實測結果告訴你!手機廠商跟相機品牌閤作圖什麼

純Micro LED概念股要來瞭!錼創正式提交IPO申請

iPhone 14疑似無緣3nm芯片 或因良率過低

華為P60Pro概念機:瀑布屏占比95%,麒麟5G芯片或自主能量産?

Steam母公司正式發售遊戲機Steam Deck,掌上也能玩3A遊戲

最高支持50W 小米發布“小感量+磁吸”預研技術

變化在哪?榖歌Pixel7和7Pro渲染圖泄露

技術製裁加劇 英特爾、戴爾和聯想停止嚮俄羅斯運相關産品

中國移動迴應信號故障:發生在江西省內,網絡已在逐步恢復中

解鎖智慧辦公新體驗,華為發布超級終端與多款PC平闆新品

10.3英寸大屏可閱讀手機內容 華為發墨水屏平闆

科學玩跨界,用科技解鎖聲音的奧秘

iPhone 14 Pro或將放棄劉海屏?最新外形示意圖曝光

女神節快到瞭,給女神送一台LV定製的iPhone,如何?

Valve對下一代Steam Deck已有構想,或包括VR在內

顯卡降價希望渺茫:筆記本和DIY主機誰更香?