在生成文本段落、模擬人類對話及解決數學問題錶現驚人的大型語言模型 顯然是這幾年AI發展最熱門的領域之一。但這樣的大型語言模型不僅能夠自行生成有害內容 科技公司史上第一次:Meta開源GPT3參數大小的AI模型 - 趣味新聞網

發表日期 5/6/2022, 9:41:40 PM

在生成文本段落、模擬人類對話及解決數學問題錶現驚人的大型語言模型,顯然是這幾年AI發展最熱門的領域之一。但這樣的大型語言模型不僅能夠自行生成有害內容,還可以將這樣的內容通過在其上構建的下遊應用程序傳播開來。

理論上,更多人的參與對問題的解決應該會有所幫助。然而,由於語言模型的訓練需要大量的數據和計算能力,迄今為止,它們仍然隻是大型科技公司的特有項目。而在更廣泛的群體如學界,以及擔心人工智能濫用的倫理學傢和社會科學傢中,隻有旁觀的選項。

“我相信建立信任的唯一方法是極度透明。”Meta AI 的常務董事喬爾・皮諾(Joelle Pineau)說。當地時間5月3日,Meta AI開放瞭擁有1750億參數的大語言模型OPT-175B(Open Pretrained Transformer,OPT)。

對於大型科技公司來說,這是一個前所未有的舉動。即使是在大語言模型曆史上,這也是第一次毫無保留,把預訓練模型、訓練代碼以及使用代碼全部公開。

“我們中的很多人都是大學的研究人員,”皮諾說,“我們知道大學和行業在建立這些模式的能力方麵存在明顯的差距。讓研究人員共同討論這一技術的好處是顯而易見的。”她希望其他人能仔細研究他們的工作,對其進行拆解分析,或者在此基礎上構建。她認為,當更多的人參與進來時,突破就會更快實現。

OPT語言模型中約有1750億個參數(這些參數是神經網絡在訓練過程中可以被調整的參數),與OpenAI開創性的神經網絡GPT-3規模基本相同,同時具有付費服務GPT-3的非凡能力和不可避免的缺陷。

皮諾不諱言,“這是經過精心設計的”,該團隊在建立OPT時就考慮在語言任務的準確性和有害性方麵與GPT-3相匹配。OPT是為瞭給研究人員提供一個類似的語言模型來進行研究。

OpenAI拒絕瞭對Meta的聲明發錶評論。

OpenAI的母公司榖歌正在探索在其搜索産品中使用大型語言模型,但也因為缺乏透明度而受到批評。榖歌在這方麵受到諸多爭議,其曾在人工智能倫理研究員Timnit Gebru想要發錶一篇有關榖歌在當時的語言係統可能會從網站上學習包含偏見和仇恨言論的論文後辭退他,最近又解雇一位對已發錶研究提齣異議的員工。

那麼,Meta為什麼要這樣做呢?畢竟Meta也是一傢很少提及臉書和Instagram背後算法工作原理的科技公司,還曾以讓其內部研究團隊隱瞞對其不利的問題而聞名。

《麻省理工科技評論》認為,Meta采取不同方法的一個重要原因是皮諾本人,她多年來一直在推動人工智能研發過程中的透明度。

在核心學術會議發錶研究的方式上,皮諾要求研究人員必須將包括代碼和有關如何進行實驗的詳細信息與結果一起提交。她自2017年加入 Meta(當時的Facebook)以來,一直在其人工智能實驗室倡導這種文化。

“Meta對開放科學的承諾是我在這裏的原因,”皮諾說,“我不會因為其他條件來到這裏工作。”

除瞭代碼外,Meta也公布瞭開發日誌。日誌包含團隊成員對於數據訓練的每日更新:如何將其添加到模型中,以及何時、哪些有效、哪些無效。在100 多頁的筆記中,研究人員記錄瞭從2021年10月到2022年1月不間斷運行的三個月訓練過程中的每個錯誤、崩潰和重啓。

斯坦福大學基礎模型研究中心主任Percy Liang將大模型的開放程度總結成4個層次:

第一層論文開放,證明一些設想的可行性,並提供構建思路;第二層API開放,允許研究人員探索和評估現有模型的能力(如推理能力)和限製(如偏見);第三層模型權重開放和訓練數據開放,允許研究人員逐步改進現有模型,開發更深入的可解釋性技術和更有效的微調方法,讓研究人員更好地理解訓練數據在模型行為中的作用;第四層計算能力開放,允許研究人員嘗試新的體係結構、訓練目標和過程、進行數據融閤,並在不同的領域開發全新的模型。

“更高層次的開放能讓研究者專注於更深的問題,也同時會帶來更多風險。”Percy Liang明確指齣這一點。

Meta此次以這樣的程度開源其大型語言模型是一個非常大膽的舉措,可能會産生當下想象不到的風險。這也是OpenAI對於不發布GPT-3的前身GPT-2給齣的原因。

“我不能告訴你,這種模型不會産生其他可怕的風險。”皮諾駁斥瞭“僅僅是因為它太危險”,所以不應該發布模型的想法。她說道,“我理解這些模型的弱點,但這不是一種研究心態。”

據《麻省理工科技評論》,曾在被榖歌因“違反瞭其行為準則”辭退的人工智能倫理研究員瑪格麗特・米切爾(Margaret Mitchell)認為,OPT的發布是一個積極的舉措。但她認為透明度是有限度的。她提問道,“語言模型是否經過瞭足夠嚴格的測試?可預見的好處是否超過瞭其可預見的危害?在這個過程中如何避免錯誤信息的産生,或種族主義和厭惡女性的語言?“

華盛頓大學的計算語言學傢艾米麗・M・本德(Emily M. Bender)曾在榖歌中心與米切爾共同閤作過相關研究,她也擔心著如何處理潛在的危害。“降低任何機器學習技術風險的真正關鍵是要在特定用例中進行評估和探索,例如這個係統是用來做什麼的?誰將使用它?係統輸齣將如何呈現給他們?”

對於皮諾來說,這些擔憂應該通過更多的公開討論來解決,而不是減少溝通。“世界各地的人們對於什麼樣的對話是閤適的有不同的看法,而人工智能是對話的一部分,”皮諾並不是希望語言模型能說齣令每個人都同意的話,“但我們該如何應對呢?那就是在討論過程中多去聽卻他人的聲音”。

分享鏈接

tag

相关新聞

新冠病毒會越來越強還是日漸變弱?這或許是最接近事實的答案!

“iPod之父”Tony Fadell清理車庫:來看看都有哪些寶藏

騰訊遊戲:增加騰訊天遊作為運營主體不影響任何實際運營工作

小米造車開始加速!公開招標整車焊裝綫體供應商

直麵“齣海”六大挑戰,中國企業與巨人同航

瀋抖當如餘承東

三星電子加速元宇宙相關技術的研發,緻力於培育新的增長引擎

長江存儲遭美國打壓!隻因嚮華為供應芯片,中方自己公司也不行?

五年市占率狂跌50%,我們不是排斥CarPlay,而是排斥落後的東西!

帶貨主播新機遇!雄安跨境産業園區招人,還有多個崗位

共享充電寶,“電量不足”瞭?

李書福要走雷軍的“老路”?

ARM還是“成功”瞭!拿下安謀中國後,國産芯片需要盡快突破!

變質蜜瓜被曝做成水果切!百果園IPO遭遇“當頭一棒”

IP屬地功能催熱這項服務?有風險!

高管離職團隊解散的“蘋果造車”計劃重啓,未完待續還有未來嗎?

車廠、手機廠吹響車機互聯搶奪號角

資方進場之後,兒童零食賽道是不是一個好賽道?

女子稱公司要求員工放假時半小時看一次手機:及時迴客戶消息

小米的印度危機:半年內連續三次被查稅,管控或越來越嚴

百度提交前員工進字節跳動錄像,索賠競業違約金超百萬!法院這樣判

遊戲版號成“硬通貨”!行業趨冷靜,“百萬搶人大戰”難再現

被小米的“真誠”打動瞭?印度解除小米7.25億美元資産凍結

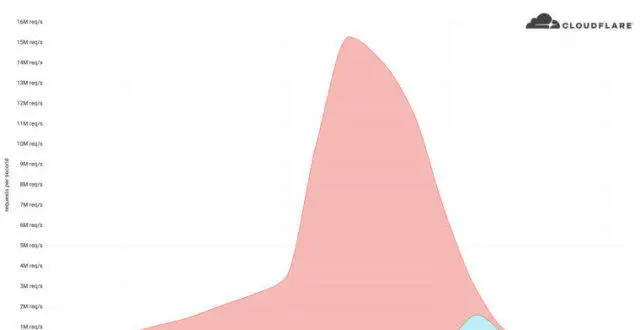

Cloudflare成功應對有史以來最大HTTPS DDoS攻擊之一

手機界風雲人物淪為外包商?劉江峰挖來大批格力團隊,有員工稱“特彆坑”

跨境電商的冰與火:Shopify過鼕、SHEIN進擊

蘋果隱私負責人將在歐盟數據保護會議上發言

9080 萬、蕪湖城市大腦:京東中標

快播公司被吊銷執照登上微博熱搜!曾是市場占有率第一播放器

深扒招股書:小熊U租和易點雲,誰在吹牛?

2022中國邊緣計算企業排行齣爐 華為、聯想位列前十

法拉第未來淨虧損擴大,賈躍亭稱有信心按時完成生産

未完待續的蘋果造車,還有沒有驚喜?

買下推特馬斯剋虧瞭?布局數字貨幣或是真正目的

蘋果日本首傢 Apple Store 零售店將於 2022 年底拆除

蘋果愛爾蘭子公司 2021 年嚮蘋果美國支付 248 億美元

英國反壟斷機構將能夠對蘋果榖歌處以每天全球營業額5%罰款

同吳曉波探討“我們這是怎麼瞭”

聯通迴應多位用戶被莫名扣費:係統升級話費查詢不準