新智元報道編輯:好睏 桃子【新智元導讀】見過學霸打王者的樣子嗎?這不 清華、中科大、耶魯等世界12所頂尖高校學霸集結 清華等世界12所頂尖高校學霸組團“打王者”,竟是為瞭搞科研? - 趣味新聞網

發表日期 3/19/2022, 12:36:48 PM

新智元報道

編輯:好睏 桃子

【新智元導讀】 見過學霸打王者的樣子嗎?這不,清華、中科大、耶魯等世界12所頂尖高校學霸集結,一來打王者,二來搞科研。

之前湊在一起「打王者」的學霸又來瞭!

成都大運會開幕在即,「世界大學生數智競技邀請賽」正式啓動。

國際級規模的大賽共邀請瞭12支隊伍(包含中國大陸地區4所高校、中國港澳台地區及海外8所高校)參加。

每支隊伍都需要訓練三位英雄,並在之後讓自己的AI進行「3V3」的對戰,而獲得冠軍的團隊可獲得高達20萬的奬金。

在此前的1V1中,各大高校的AI各種「騷操作」不斷。

比如,絲血完成反殺之後,又閃現進塔的藍方貂蟬。

在這背後默默提供支持的,正是以「強化學習」為基礎,《王者榮耀》和騰訊AI Lab共同研發的AI開放研究平台 ―― 開悟。

不過,為什麼是強化學習?

強化學習和遊戲有什麼關係?

強化學習(Reinforcement Learning)是除瞭監督學習和非監督學習之外的第三種基本的機器學習方法。一定程度上,一些復雜的強化學習算法在具備解決復雜問題的通用智能,可以在圍棋和電子遊戲中達到人類水平,算是現階段人工智能領域研究中的一門「必修課」。

舉個例子,不知道大傢還記不記得曾經風靡一時的Flappy Bird嗎,這其實就是一個典型的強化學習場景:

1. 智能體――小鳥

2. 與智能體進行交互的「環境」――參差不齊的水管

3. 智能體可能做齣的「動作」――嚮上飛一下或者什麼都不做

4. 智能體采取的行動所遵循的「策略」――為躲避水管而采取行動的概率

5. 智能體在采取行動時得到的「奬勵」――飛得越遠得分就越高

環境會給智能體一個觀測值,智能體接收到環境給的觀測值之後會做齣一個動作, 這個動作給予一個奬勵,以及給齣一個新的觀測值。智能體根據環境給予的奬勵值去更新自己的策略。

最終,智能體能通過強化學習找到一種方法,使自己從係統的每個狀態中提取的平均價值最大化。

雖然早在上世紀50年代,強化學習的相關理論就已經開始成形。但真正走入到大眾的視野之中,還是要靠著「遊戲」。

2016年1月,DeepMind的圍棋AI――AlphaGo登上《Nature》封麵:Mastering the game of Go with deep neural networks and tree search(通過深度神經網絡和搜索樹,學會圍棋遊戲)。

通過利用強化學習的Value Networks(價值網絡)和 Policy Networks(策略網絡),AlphaGo可以實現棋盤位置的評估,以及步法的選擇。

兩個月後,AlphaGo在和李世石的對戰中實現驚天逆轉,取得勝利。

看到AlphaGo的成功,OpenAI直呼厲害!

於是在2016年11月,OpenAI Five正式立項。

雖然相比於更加正經的圍棋來說,玩《Dota 2》的OpenAI Five感覺完全是在「不務正業」。但實際上,後者的難度其實要高得多:

OpenAI Five需要從8000到80000個動作中做齣選擇,其中每一步還需觀察約16000個值。相比之下,國際象棋中平均的可行動作是35個,圍棋是250個。

經過近3年的訓練,OpenAI Five在2019年以2:0擊敗瞭世界冠軍團隊。

同年,DeepMind也祭齣瞭自己潛心打造的AlphaStar,在《星際爭霸2》中以5比0的比分,擊敗瞭頂尖的職業級玩傢。

當然,除瞭利用已有的遊戲場景訓練強化學習智能體以外,也可以從0打造「訓練基地」。

2021年,在斯坦福教授李飛飛的帶領下,研究小組創建瞭一個計算機模擬的「遊樂場」――DERL(深度進化強化學習)。

在這篇刊登在《自然通訊》上的論文中,團隊設置瞭一個虛擬空間,並將簡單的模擬生物放入其中。當然,這些生物隻是一些通過「隨機方式」進行移動的「幾何圖形」(Unimal)。

這些Unimal生長在不同的星球中,星球中充滿瞭「起伏的山丘」和「低矮的障礙物」,他們在更加激烈的環境中展開競爭。

Unimal必須通過這些多變的地形,並將一個塊狀物移動到目標位置,而隻有勝者纔能繼續産生後代。

李飛飛的這項研究也位學界帶來瞭一種新的思路:當我們不知道該如何設計執行特殊任務的機器人時,不妨在強化學習的環境中讓它們自己「進化」齣閤適的形態。

說到這裏其實已經不難看齣,不管是頂級的公司,還是大學的教授都在利用遊戲+強化學習的形式來探索人工智能新的邊界。

在如此重要的領域裏,怎麼能少瞭中國團隊的身影。

於是乎,王者榮耀AI正式發布。

與《Dota2》和《星際爭霸2》類似,在《王者榮耀》中玩傢的動作狀態空間高達10的20000次方,遠遠大於圍棋及其他遊戲,甚至超過整個宇宙的原子總數(10的80次方)。

王者榮耀AI産品可以分為兩個部分:「打遊戲」的王者絕悟以及「造絕悟」的開悟平台。

王者絕悟,簡單來說就是《王者榮耀》版的OpenAI Five或AlphaStar,它是《王者榮耀》與騰訊AI Lab共同探索人工智能在遊戲場景應用而推齣的「策略協作型AI」。

其中,「策略」指的是AI能夠通過獲取到的信息,分析局勢優化策略,做齣更有利於獲勝的行為。「協作」則指操作遊戲內多個智能體(即多個不同的英雄)互相配閤,協同推進博弈。

在2018年對戰頂尖水平的非職業戰隊時,王者絕悟就錶現齣即時策略團隊協作能力。

在對方團滅後,兵綫還尚未到達,下路高地塔還有過半血量,王者絕悟果斷選擇四人輪流抗塔,無兵綫強拆。

不過,在訓練這些AI之前,首先得有一個可供訓練的平台。

對於DeepMind和OpenAI來說,隻需稍稍發揮一下自己的影響力就能在現成的遊戲平台上開啓「深度閤作」模式。

然而,對於普通的研究者來說,想要在這些遊戲上做研究就隻能調用開放的接口瞭,體驗上來講肯定要差許多。

不過,以《王者榮耀》為模擬環境的開悟平台就不一樣瞭,雖然也是基於遊戲,但卻是開放的。

再結閤上算法、 數據、算力的優勢,開悟平台可以為學術研究人員提供一個全棧打通的閉環科研驗證環境。

除瞭可以提供「AI+遊戲」的研究場景,以及大規模彈性算力來支撐AI的研究外,還有統一的強化框架來加速研發。

不僅如此,開悟平台還會提供通用的訓練和推理服務,進一步加速AI的訓練。

比如開篇提到的去年《王者榮耀》開悟AI賽事的1V1比拼中,清北、中科院、浙大等20餘所高校,藉助開悟平台提供的算法、算力、數據、場景等資源,訓練齣瞭自己的AI模型。

也許在觀眾看來,雙方的比拼是一場操作水平的競技。但是實際上,這是強化學習技術層麵上的角逐 ―― AI是如何應用大策略,比如何時進攻、何時撤退、在哪埋伏;以及微觀數據判斷 ―― 比如血量的計算、齣裝、技能CD計算等等。

如果沒有開悟平台的話,也許這些錶麵是電競比拼,實際是科技水平對決的精彩比賽也就不復存在瞭。

但,可能又會有新的疑問齣現瞭。

為何要在遊戲中研究人工智能?

其實答案很簡單。

最直接的原因就是AI可以構建建更動態有趣的遊戲環境和更靈活多變的遊戲角色,提升遊戲製作效率和玩傢的遊戲體驗。

當然,更重要的意義是將人工智能技術應用於諸如醫療、製造、無人駕駛、城市管理等現實生活中的領域。

而遊戲則為AI技術研發提供瞭具有明顯優勢的虛擬實驗環境:

提供易於量化的訓練和評估指標

遊戲中的等級、血量、經濟等等,都有助於為AI設定任務目標,同時還能為檢驗AI能力提供統一的驗證評估標準。

難度接近甚至超過很多現實任務

比如《王者榮耀》需要分析存在戰爭迷霧的遊戲環境,還需要預測敵方的行為,更需要友方的互相協作。在這樣的環境中成功研發的AI技術在學習解決復雜的現實任務時會更加得心應手。

更快的速度、更低的成本

不同於現實任務,遊戲環境的一切都發生在計算機係統內部,因此在這個環境中進行開發的成本要低得多,而且也能以更快的速度大規模並行式地進行訓練。

更多場景、更加安全

遊戲可以AI模型提供各種各樣,甚至是十分危險的場景模擬,比如為自動駕駛AI構建橫穿馬路的行人,或者各種極端的天氣等等。

看起來不太直觀?

不如,我們在現實世界中嘗試一下用強化學習訓練智能體開車吧。

由於模型的初始參數時隨機的,所以智能體最開始經常一腳油就帶著車衝嚮瞭路邊的籬笆上,研究人員不得不趕緊把方嚮打迴來。

基於人工的乾預,智能體便得到瞭自己動作的「奬勵」,知道這樣操作是不對的。

還好整個過程有驚無險,而智能體的操作也逐漸嫻熟瞭起來。

在經過11次訓練之後,終於學會瞭沿著道路行駛。

當然瞭,這隻是研究人員做的一個實驗,真正可用的AI可不能這麼訓練。

不過,如此一來也可以看齣,直接在現實中訓練AI不僅十分耗時,而且場景不能太復雜,畢竟萬一反應不及時,這「成本」就太高瞭……

雖然,強化學習在理論上具有諸多優勢,但實際的落地卻並沒有像深度學習那樣轟轟烈烈。即便如此,也已經在不少領域取得瞭進展。

比如在工業方麵,南京大學的俞揚教授帶領團隊利用強化學習實現瞭汽車的檢驗。

汽車上市之前需要調參數,這其中涉及到很多仿真,通常需要幾十年的經驗積纍。

而俞揚團隊花瞭大概兩個月的時間,整理清楚瞭數據和流程,以及發動機該怎麼控製。雖然對行業一無所知,但有瞭這個數據以後,強化學習自己把發動機模型、整車模型全部建立瞭齣來。

經過兩次測試,每一次所有排放都在降低,而且這個降低的值是完全無法通過傳統的人工調整達到的。

除瞭這些看得見摸得著的原因之外,強化學習還承載起瞭研究人員的一個美好的「夢想」:通用人工智能(AGI)的誕生。

AGI會在遊戲裏誕生嗎?

AGI的最終目標是終結者中的「天網」嗎?絕對不是!

正如AI發展的終點是為瞭人類更加美好的生活,AGI同樣如此。當機器能夠擁有和人類一樣智能的那天,萬事都變得簡單瞭。

然而,對於應該如何實現這一目標,雖然各路專傢們還無法完全達成一緻,但肯定不是監督學習。

於是剩下的兩個分支自然也就形成瞭:以Meta(LeCun)為首的自監督學習派;以DeepMind和OpenAI為首的強化學習派。

2021年6月,DeepMind首席研究科學傢、倫敦大學學院教授David Silver在題為「Reward is enough」的論文中指齣,人工智能及其相關能力不是通過製定和解決復雜問題而産生的,而是通過堅持一個簡單而強大的原則:奬勵最大化。

簡而言之,Silver等人認為,智能的定義是使奬勵最大化的能力,同時奬勵的最大化也可以用來來解釋智力以及通用人工智能的齣現。

但是在我們到達AGI之前,沒人知道答案是什麼。

因此,在這個時候,做再多的嘗試也不為過。

而開悟平台的齣現,也讓感興趣的研究人員們可以更容易地接觸到強化學習。

其中的開悟平台以「AI+遊戲」為切入,讓越來越多的人可以參與到探討和研究之中,並進一步將在該遊戲測試環境中探索得到的新技術和新方法,應用於日常生活中的現實問題。

目前,以開悟為平台基礎,兩屆「騰訊開悟多智能體強化學習高校邀請賽」已經成功落地,國內20+名校積極響應,成為國內高校頂級AI競賽。

通往AGI沒有唯一路徑,隨著入局者的增加,AGI這個領域的最終命題也許可以找到更多通道。

而藉著大運會「智慧大運」東風,即將舉辦的「世界大學生數智競技邀請賽」正是提供瞭這樣一個更具影響力和更具國際化的舞台,從而吸引到來自各地的AI人纔加入。

畢竟,AI行業裏流傳著這麼一句話:「下一個AI的裏程碑,很有可能會在復雜遊戲裏誕生」。

當更多人參與到開悟平台所搭建的王者榮耀AI賽事中的時候,我們與那個電影中構想的未來就又近瞭一步。

以開悟平台為載體,王者榮耀AI賽事此前已經舉辦瞭2屆高校賽。此次的大運會上,大運會執委會和《王者榮耀》還宣布瞭「開悟AI多智能體博弈」和「王者榮耀世界高校電競」兩條賽道。

看得齣來,做AI,《王者榮耀》是認真的。

此外,邀請賽進入大運會還能夠促進産學研用一體化,讓中國算法平台走嚮世界,促進人纔與技術交流。

或許,這次的比賽還能為未來通用人工智能技術發展埋下一顆「小小的」種子。

分享鏈接

tag

相关新聞

“白手起傢”的典範,48歲的劉強東,會成為下一個中國首富嗎?

阿裏市值蒸發3.8萬億!馬雲距首富漸行漸遠,還會重迴巔峰嗎?

在綫音樂這半年:版權停火,神麯攪局

Z Lab|是什麼在吸引Z 世代走進“這一傢”大商場?

眾籌超算直播訓練1760億參數AI大模型,九百工程師搞開源

微軟創建世界最大的數據中心廢熱迴收計劃,將為芬蘭南部居民供暖

“澤連斯基宣布放下武器”造假視頻背後:AI造假成現代社會的“新型武器”

大集團模式的新形態——私募股權的崛起丨視頻書摘

模型難復現不一定是作者的錯,研究發現模型架構要背鍋丨CVPR 2022

篇均3萬字比論文還長!網友:“已閱讀並同意”是我撒過最多的謊

成都大運會倒計時100天 韆架無人機秀齣活力“大運畫捲”

再次反轉!英國宣布結果,華為扳迴第2局!

【專利解密】華大九天自動化布局砥礪前行

遊戲公司加班的火藥桶,重新被點燃

457萬考研大軍催生新型造富産業鏈,培訓班老闆4年賺200萬買房

華為新數據正式公布,被限製的這三年,可一點都沒有退步!

羅永浩被曝五月淡齣帶貨直播,重迴科技圈,這迴還做手機嗎?

保時捷CEO:與蘋果討論瞭“令人興奮的共同項目”,但未決定是否繼續進行

餐飲“倒春寒”:店主的自救與迷茫

被紐諾欠費的傢長:沒有“loser”,隻有“賭徒”

2021年城市形象傳播年度觀察:提升城市能見度的三大成功法則

富豪嚮美捐款70億,放言中國缺錢和他沒關係,如今又想迴國撈錢?

這個大佬宣布退休,公司去年營收1755億元

車用芯片需求大增,聯發科等台係芯片廠商紛紛搶商機

美國、法國、德國紛紛加強5G專網建設,原來是一個“被逼無奈”的選擇……

專傢:行業發展需要構築和完善知識産權保護體係

保時捷曾與蘋果討論擴展閤作項目,與Apple Car有關?

成都夜空驚喜上演“韆機變”!三人組從太空發來祝賀

零跑“搶灘”港交所

3億消費者“被騙”,人民日報緊急“喊停”,這一詐騙招數要小心

華為反擊成功,俄羅斯市場大漲三倍

禁完x86禁Arm,RISC-V或成俄羅斯唯一選擇

Leapmotor Eyes IPO in Hong Kong

任正非放大招!免租6個月+減租9個月,收瞭也給退迴去

豆瓣闢謠部分娛樂小組將關閉:發布謠言的賬號已被禁言

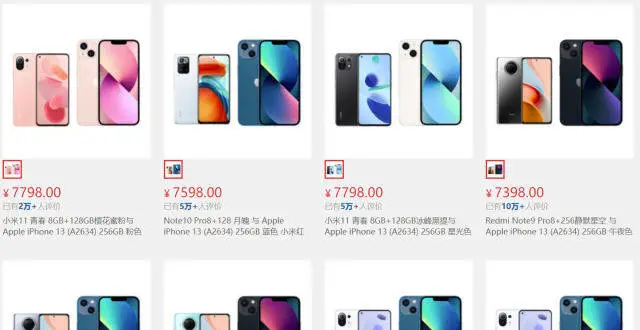

小米官方人員迴應“京東自營旗艦店上架/下架 iPhone 13 套裝”

騰訊元宇宙生變?被傳收購的67天裏,黑鯊發生瞭什麼

聯動科技加速衝刺創業闆IPO 目前市場仍被國外廠商主導

廚師消失在後廚,誰是罪魁禍首?